Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jakub Pachocki

OpenAI

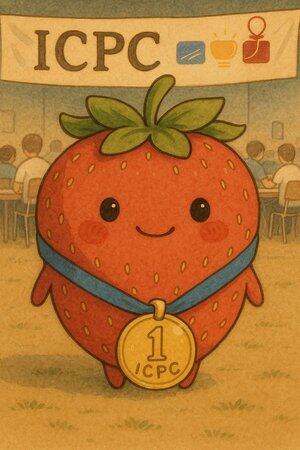

La semana pasada, nuestros modelos de razonamiento participaron en el Concurso Internacional de Programación Universitaria (ICPC) 2025, la principal competencia de programación a nivel universitario del mundo. Nuestro sistema resolvió los 12 de 12 problemas, un rendimiento que habría colocado en primer lugar en el mundo (el mejor equipo humano resolvió 11 problemas).

Este hito cierra dos meses intensos de actuaciones competitivas de nuestros modelos:

- Un segundo lugar en las Finales Mundiales de Heurísticas de AtCoder

- Medalla de oro en la Olimpiada Internacional de Matemáticas

- Medalla de oro en la Olimpiada Internacional de Informática

- Y ahora, una medalla de oro, primer lugar en las Finales Mundiales del ICPC.

Creo que estos resultados, provenientes de una familia de modelos de razonamiento general arraigados en nuestro programa de investigación principal, son quizás el indicador más claro de progreso este año. Estas competiciones son grandes pruebas autoconclusivas y limitadas en el tiempo para la capacidad de descubrir nuevas ideas. Incluso antes de que nuestros modelos fueran competentes en aritmética simple, miramos hacia estos concursos como hitos de progreso hacia una inteligencia artificial transformadora.

Nuestros modelos ahora se clasifican entre los mejores humanos en estos dominios, cuando se les plantean preguntas bien especificadas y se les restringe a ~5 horas. El desafío ahora es pasar a problemas más abiertos y horizontes de tiempo mucho más largos. Este nivel de capacidad de razonamiento, aplicado durante meses y años a problemas que realmente importan, es lo que buscamos: automatizar el descubrimiento científico.

Este rápido progreso también subraya la importancia de la investigación en seguridad y alineación. Aún necesitamos más comprensión de las propiedades de alineación de los modelos de razonamiento de larga duración; en particular, recomiendo revisar los hallazgos fascinantes del estudio sobre la planificación en modelos de razonamiento que publicamos hoy.

¡Felicidades a mis compañeros de equipo que pusieron su corazón en obtener estos resultados de competencia, y a todos los que contribuyen a la investigación fundamental subyacente que los hace posibles!

Mostafa Rohaninejad18 sept 2025

1/n

I’m really excited to share that our @OpenAI reasoning system got a perfect score of 12/12 during the 2025 ICPC World Finals, the premier collegiate programming competition where top university teams from around the world solve complex algorithmic problems. This would have placed it first among all human participants. 🥇🥇

679,76K

Estoy extremadamente entusiasmado con el potencial de la fidelidad e interpretabilidad de la cadena de pensamiento. Ha influido significativamente en el diseño de nuestros modelos de razonamiento, comenzando con o1-preview.

A medida que los sistemas de IA gastan más trabajo informático, por ejemplo, en problemas de investigación a largo plazo, es fundamental que tengamos alguna forma de monitorear su proceso interno. La maravillosa propiedad de los CoT ocultos es que, si bien comienzan basados en un lenguaje que podemos interpretar, el procedimiento de optimización escalable no es adverso a la capacidad del observador para verificar la intención del modelo, a diferencia de, por ejemplo, la supervisión directa con un modelo de recompensa.

La tensión aquí es que si los CoT no estuvieran ocultos por defecto, y vemos el proceso como parte de la producción de la IA, hay muchos incentivos (y en algunos casos, necesidad) para supervisarlo. Creo que podemos trabajar hacia lo mejor de ambos mundos aquí: entrenar a nuestros modelos para que sean excelentes para explicar su razonamiento interno, pero al mismo tiempo conserven la capacidad de verificarlo ocasionalmente.

La fidelidad al CoT es parte de una dirección de investigación más amplia, que es la capacitación para la interpretabilidad: establecer objetivos de una manera que entrene al menos a parte del sistema para que siga siendo honesto y monitoreable con escala. Continuamos aumentando nuestra inversión en esta investigación en OpenAI.

Bowen Baker16 jul 2025

Modern reasoning models think in plain English.

Monitoring their thoughts could be a powerful, yet fragile, tool for overseeing future AI systems.

I and researchers across many organizations think we should work to evaluate, preserve, and even improve CoT monitorability.

264,79K

Parte superior

Clasificación

Favoritos