Topik trending

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

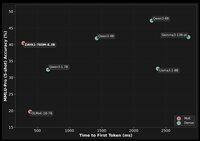

Melakukan lebih banyak dengan jauh lebih sedikit — beberapa tolok ukur model open source terkemuka.

"Meskipun beroperasi pada sebagian kecil dari jumlah parameter aktif, basis ZAYA1 (760 juta aktif) mencapai kinerja yang sebanding dengan model terkemuka seperti Qwen3-4B (Alibaba) dan Gemma3-12B (Google), dan mengungguli model termasuk Llama-3-8B (Meta) dan OLMoE di seluruh tolok ukur penalaran, matematika, dan pengkodean."

Bagan pertama — detail tentang Perhatian Konvolusional Terkompresi (CCA) Zyphra:

P.S. tanggapan terhadap tagline saya: "Zyphra secara ironis *adalah* DeepSeek dari Barat... paling tidak karena ini adalah salah satu laboratorium Barat yang paling terbuka *dan* secara demografis (sementara DeepSeek tentu saja 100% Cina). Ketelitian matematika dan budaya ilmiah." —

+ Blog Teknis: dan

+ Makalah Teknis:

+ Wajah Memeluk:

Teratas

Peringkat

Favorit