Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

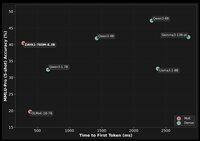

Meer doen met een heleboel minder — enkele benchmarks van de toonaangevende open source modellen.

"Ondanks dat het opereert met een fractie van het actieve aantal parameters, bereikt ZAYA1-base (760m actief) prestaties die vergelijkbaar zijn met toonaangevende modellen zoals Qwen3-4B (Alibaba) en Gemma3-12B (Google), en overtreft het modellen zoals Llama-3-8B (Meta) en OLMoE op het gebied van redeneren, wiskunde en codering benchmarks." —

Eerste grafiek — details over Zyphra's Gecomprimeerde Convolutionele Aandacht (CCA):

P.S. de reactie op mijn tagline: "Zyphra is ironisch genoeg *de* DeepSeek van het Westen... niet in de laatste plaats omdat het een van de meest open *en* demografisch Westerse laboratoria is (terwijl DeepSeek natuurlijk 100% Chinees is). Wiskundige nauwkeurigheid en wetenschappelijke cultuur." —

+ Technische Blog: en

+ Technisch Papier:

+ Hugging Face:

Boven

Positie

Favorieten