Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

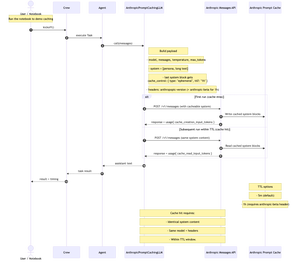

Tocmai am publicat un blocnotes Jupyter concis, pas cu pas, care arată cum să construiți un LLM personalizat pentru @crewAIInc care apelează API-ul Messages al @AnthropicAI și implementează cache prompt.

Ei bine, ce este cache prompt și când ar trebui să-l utilizați în echipajul dvs.?

Este o modalitate de a memora în cache partea lungă și repetată a solicitării (de obicei contextul sistemului) între apelurile API. îl trimiți o dată, apoi apelurile ulterioare îl refolosesc; reducerea costului de intrare cu ~90% și accelerarea timpului până la primul token cu ~85% pentru solicitările lungi, atâta timp cât conținutul sistemului + modelul + anteturile rămân aceleași și sunteți în TTL (5m implicit, 1h beta).

Acest lucru funcționează excelent pentru echipele vorbărețe, cu mai multe ture. De asemenea, util de fiecare dată când echipajul reutilizează un context de sistem lung și stabil în toate sarcinile (gândiți-vă: manual, specificații, rezumatul bazei de cod). Dacă sistemul/contextul tău se schimbă la fiecare apel, stocarea în cache nu va ajuta prea mult.

cartea de bucate folosește "Frankenstein" din Proiectul Gutenberg pentru a demonstra stocarea în cache cu un context real și lung.

Diagrama de mai jos: Prima rulare scrie în cache; rulările ulterioare citite din cache atunci când conținutul sistemului, modelul și anteturile se potrivesc în TTL.

repo + notebook în comentarii.

937

Limită superioară

Clasament

Favorite