Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Vad krävs för att en dator ska lära sig reglerna för RNA-basparning?

Människor tränar stora språkmodeller för förutsägelse av RNA-struktur. Vissa av dessa modeller har hundratals miljoner parametrar.

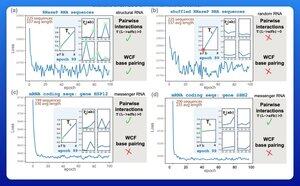

Ett spännande tidigt resultat har varit att dessa modeller lär sig reglerna för Watson-Crick-Franklin basparning direkt från data.

En forskargrupp vid Harvard bestämde sig för att se vilken som var den minsta möjliga modellen som kunde uppnå detta resultat.

De tränade en liten probabilistisk modell med endast 21 parametrar med hjälp av gradient descent.

Med så få som 50 RNA-sekvenser – utan motsvarande strukturer – skulle reglerna för basparning dyka upp efter bara några få träningsepoker.

Så svaret på deras ursprungliga fråga var att det krävs "mycket mindre än du kanske tror" för att lära dig den här typen av modell.

Jag tror inte att det betyder att de storskaliga utbildningsinsatserna nödvändigtvis är dumma eller missriktade. Men det här resultatet tyder på att det finns en hel del effektivitet och prestanda som fortfarande kan utvinnas ur arkitekturinnovation.

Det finns en hel del underliggande struktur i biologins språk.

3,61K

Topp

Rankning

Favoriter