Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

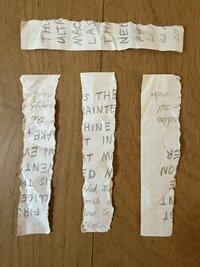

ChatGPT o3-pro identifiserer et sitat fra 1965 av I. J. Good håndskrevet i en blanding av trykk og kursiv på en revet i fire strimler i omvendt rekkefølge rotert 90° i vekslende retninger:

… og igjen, med de samme stripene krøllet, flatet for hånd og ordnet annerledes:

Hardere variasjoner med okklusjoner av husholdningsgjenstander var imidlertid ikke vellykkede – i ett tilfelle ga det en ironisk tilbakevisning av teksten som faktisk ble skrevet:

Merk at rettsmedisinsk programvare i den virkelige verden er mye kraftigere enn tbis, og kan "makulere" flersidige dokumenter som kjøres gjennom typiske makuleringsmaskiner på kontoret etter nøye skanning.

Dette er mer en nyhet – det er interessant bare fordi det ikke ble designet for å kunne gjøre dette.

Merk at rettsmedisinsk programvare i den virkelige verden er mye kraftigere enn dette, og kan "makulere" flersidige dokumenter som kjøres gjennom typiske makuleringsmaskiner på kontoret etter nøye skanning.

Dette er mer en nyhet – det er interessant fordi det ikke ble designet for å gjøre dette.

@virtualdigit @emollick Sannsynligvis ikke:

7. juli 2025

Merk at rettsmedisinsk programvare i den virkelige verden er mye kraftigere enn dette, og kan "makulere" flersidige dokumenter som kjøres gjennom typiske makuleringsmaskiner på kontoret etter nøye skanning.

Dette er mer en nyhet – det er interessant fordi det ikke ble designet for å gjøre dette.

Noen få svar har spurt i hvilken grad modellen feilkorrigerer til den kjente teksten i sitatet (noe som antyder at den kanskje ikke generaliserer like godt til ny tekst).

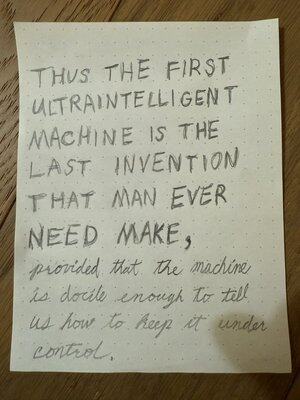

En utilsiktet feil i notatet mitt antyder at dette faktisk skjer – mitt lyder «trenger noensinne», ikke «trenger noensinne», som Good skrev:

@ShaulGoo Ikke i dette tilfellet, men gitt min spesifikke oppfordring her, er det uten tvil riktig oppførsel å ignorere små feil.

Se dette svaret jeg nettopp la til i tråden:

7. juli 2025

Noen få svar har spurt i hvilken grad modellen feilkorrigerer til den kjente teksten i sitatet (noe som antyder at den kanskje ikke generaliserer like godt til ny tekst).

En utilsiktet feil i notatet mitt antyder at dette faktisk skjer – mitt lyder «trenger noensinne», ikke «trenger noensinne», som Good skrev:

(Selv om jeg vil argumentere for min spesielle forespørsel, som antyder at det er kjent for å være et sitat, er det god oppførsel å ikke gjenta små feil i inndataene.)

@panoskalos jeg har ikke prøvd meg selv, men se her:

7. juli 2025

Det som virkelig er interessant er at @GeminiApp også kan gjøre det samme, men det trenger en litt justert melding @goodside

Jeg kjører 2.5 Pro

@panoskalos @panoskalos jeg har oppdatert hovedtråden ovenfor med flere resultater fra Gemini.

253,76K

Topp

Rangering

Favoritter