Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jeffrey Emanuel

Neocognitronen var så langt forut for sin tid. Fukushima får ikke nok anerkjennelse. Flott navn også.

Jeg håper han er berømt i Japan i det minste.

Jürgen Schmidhuber2. des., 23:20

Fukushimas video (1986) viser en CNN som gjenkjenner håndskrevne sifre [3], tre år før LeCuns video (1989).

CNN-tidslinje hentet fra [5]:

★ 1969: Kunihiko Fukushima publiserte rektifiserte lineære enheter eller ReLU-er [1] som nå er mye brukt i CNN-er.

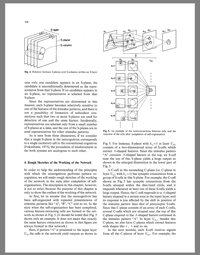

★ 1979: Fukushima publiserte den grunnleggende CNN-arkitekturen med konvolusjonslag og nedprøvingslag [2]. Han kalte det neocognitron. Den ble trent etter regler for uovervåket læring. Databehandling var 100 ganger dyrere enn i 1989, og en milliard ganger dyrere enn i dag.

★ 1986: Fukushimas video om å gjenkjenne håndskrevne sifre [3].

★ 1988: Wei Zhang et al. fikk den første «moderne» todimensjonale CNN trent ved backpropagasjon, og anvendte den også til tegngjenkjenning [4]. Beregning var omtrent 10 millioner ganger dyrere enn i dag.

★ 1989-: senere arbeid av andre [5].

REFERANSER (mer i [5])

[1] K. Fukushima (1969). Visuell funksjonsekstraksjon ved et flerlags nettverk av analoge terskelelementer. IEEE Transactions on Systems Science and Cybernetics. 5 (4): 322-333. Dette arbeidet introduserte rektifiserte lineære enheter eller ReLU-er, som nå er mye brukt i CNN-er og andre nevrale nettverk.

[2] K. Fukushima (1979). Nevralt nettverksmodell for en mekanisme for mønstergjenkjenning som ikke påvirkes av posisjonsskifte—Neocognitron. Overs. IECE, vol. J62-A, nr. 10, s. 658-665, 1979. Den første dype konvolusjonelle nevrale nettverksarkitekturen, med vekslende konvolusjonslag og nedsamplingslag. På japansk. Engelsk versjon: 1980.

[3] Film produsert av K. Fukushima, S. Miyake og T. Ito (NHK Science and Technical Research Laboratories), i 1986. YouTube:

[4] W. Zhang, J. Tanida, K. Itoh, Y. Ichioka. Skiftinvariant mønstergjenkjenning nevralt nettverk og dets optiske arkitektur. Proc. Årskonferanse for Japan Society of Applied Physics, 1988. Den første «moderne» backpropagasjonstrente todimensjonale CNN, anvendt på tegngjenkjenning.

[5] J. Schmidhuber (AI Blog, 2025). Hvem oppfant konvolusjonelle nevrale nettverk?

9,93K

Topp

Rangering

Favoritter