Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

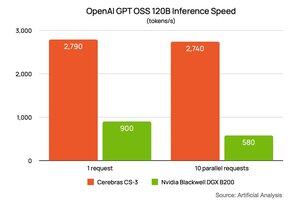

A principios de esta semana, @NVIDIA compartió su rendimiento en el modelo gpt-oss-120B de @OpenAI ejecutándose en DGX B200 (8 chips Blackwell de dos núcleos). Le pidieron a @ArtificialAnlys que hiciera una configuración especial para ellos. Mostraron un rendimiento de 900 tokens por segundo para un usuario, y bajó a 580 tokens por segundo para 10 usuarios. He pegado su enlace en los comentarios a continuación.

Le pedimos a Artificial Analysis que ejecutara la misma configuración para nosotros. El resultado es ~2700 token/s para 1 y lo mismo para 10 usuarios. No solo @CerebrasSystems Inference es el más rápido, sino que mantenemos el rendimiento a medida que escalas tu carga de trabajo. Cerebras Inference está en producción completa hoy, sirviendo miles de millones de tokens GPT 120B por semana en @OpenRouterAI, @huggingface y la Nube de Cerebras.

80,26K

Parte superior

Clasificación

Favoritos