Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

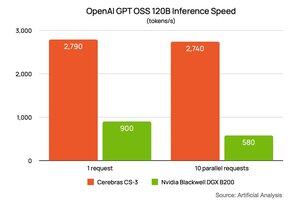

Tidigare i veckan delade @NVIDIA sin prestanda på @OpenAI s gpt-oss-120B-modell som körs på DGX B200 (8 två Blackwell-chips). De bad @ArtificialAnlys analys att göra ett speciellt upplägg för dem. De visade prestanda på 900 tokens per sekund för en användare och sjönk till 580 tokens per sekund för 10 användare. Jag har klistrat in deras länk i kommentarerna nedan.

Vi bad Artificial Analysis att köra samma upplägg åt oss. Resultatet är ~2700 token/s för 1 och detsamma för 10 användare. @CerebrasSystems Inference är inte bara snabbast, vi upprätthåller prestanda när du skalar upp din arbetsbelastning. Cerebras Inference är i full produktion idag och betjänar miljarder GPT 120B-tokens per vecka på @OpenRouterAI, @huggingface och Cerebras Cloud.

80,27K

Topp

Rankning

Favoriter