Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

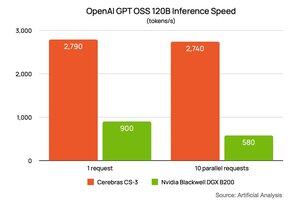

La începutul acestei săptămâni, @NVIDIA împărtășit performanța sa pe modelul gpt-oss-120B @OpenAI care rulează pe DGX B200 (8 cipuri Blackwell cu două matrițe). Au cerut analizei @ArtificialAnlys să facă o configurație specială pentru ei. Acestea au arătat performanțe de 900 de jetoane pe secundă pentru un utilizator și au scăzut la 580 de jetoane pe secundă pentru 10 utilizatori. Am lipit linkul lor în comentariile de mai jos.

Am cerut Analizei Artificiale să ruleze aceeași configurație pentru noi. Rezultatul este ~2700 token/s pentru 1 și același pentru 10 utilizatori. Nu numai că @CerebrasSystems Inference este cel mai rapid, dar susținem performanța pe măsură ce vă extindeți volumul de lucru. Cerebras Inference este în plină producție astăzi, servind miliarde de jetoane GPT 120B pe săptămână pe @OpenRouterAI, @huggingface și Cerebras Cloud.

80,21K

Limită superioară

Clasament

Favorite