Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Benchmarks in der Welt der Sprachmodelle sind wie standardisierte Tests in der Bildung.

Ein hoher SAT-Score garantiert keinen Erfolg in jedem Studienfach. Ebenso garantiert ein hoher Benchmark-Score nicht, dass ein Modell in jeder Aufgabe hervorragend abschneidet.

So interpretiert man sie weise. 🧵

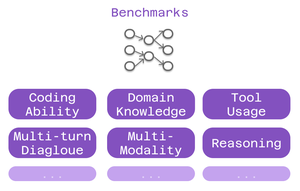

Drei Arten von Benchmarks sind für Cline-Nutzer wichtig:

> Programmierfähigkeit - kann es Code verstehen und generieren?

> Fachwissen - kennt es Ihr Gebiet?

> Werkzeugnutzung - kann es mit MCP-Integrationen arbeiten?

Verschiedene Benchmarks testen unterschiedliche Aspekte der Intelligenz.

Für das Programmieren: SWE-Bench sticht hervor.

Es testet Modelle anhand realer GitHub-Probleme aus beliebten Open-Source-Projekten. Keine künstlichen Probleme - tatsächliche Fehler und Funktionen, mit denen Entwickler täglich konfrontiert sind.

Ein starker SWE-Bench-Score = gut im Beheben von Fehlern, Implementieren von Funktionen, Refaktorisieren von echtem Code.

Domänenspezifische Benchmarks sind wichtig für spezialisierte Arbeiten:

• MMLU - 57 akademische Fächer (Gesundheitswesen, Finanzen, Wissenschaft)

• GPQA - Biologie, Physik, Chemie auf Graduiertenebene

• AIME - Fortgeschrittenes mathematisches Denken

Bauen Sie Gesundheits-Apps? Überprüfen Sie die Biologie-Ergebnisse.

Finanzmodellierung? Mathematische Leistung ist wichtig.

Benchmark-Tests zur Nutzung von Tools prüfen die Fähigkeiten von MCP:

Kann das Modell:

• Toolaufrufe korrekt formatieren?

• Geeignete Tools auswählen?

• Mehrere Tools miteinander verknüpfen?

Kritisch für Cline-Setups, die Web-Scraping, Browserautomatisierung oder erweiterte Speichersysteme verwenden.

Die Einschränkung: Benchmarks erzählen nur einen Teil der Geschichte.

Zwei Modelle mit ähnlichen SWE-Bench-Werten könnten in völlig unterschiedlichen Bereichen hervorragend abschneiden.

6,39K

Top

Ranking

Favoriten