Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Os benchmarks no mundo do modelo de linguagem são como testes padronizados na educação.

Uma pontuação alta no SAT não garante o sucesso em todos os cursos universitários. Da mesma forma, uma pontuação alta de benchmark não garante que um modelo se destaque em todas as tarefas.

Veja como interpretá-los com sabedoria. 🧵

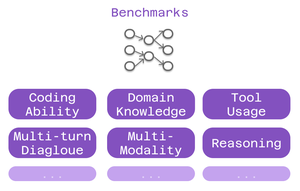

Três tipos de benchmarks são importantes para os usuários do Cline:

> capacidade de codificação - ela pode entender e gerar código?

> conhecimento de domínio - ele conhece seu campo?

> uso da ferramenta - ela pode funcionar com integrações MCP?

Diferentes benchmarks testam diferentes aspectos da inteligência.

Para codificação: o SWE-Bench se destaca.

Ele testa modelos em relação a problemas reais do GitHub de projetos populares de código aberto. Não são problemas artificiais - bugs e recursos reais que os desenvolvedores enfrentam diariamente.

Pontuação forte do SWE-Bench = bom em corrigir bugs, implementar recursos, refatorar código real.

Os benchmarks específicos de domínio são importantes para o trabalho especializado:

• MMLU - 57 disciplinas acadêmicas (saúde, finanças, ciências)

• GPQA - Nível de pós-graduação em biologia, física, química

• AIME - Raciocínio matemático avançado

Criando aplicativos de saúde? Verifique as pontuações de biologia.

Modelagem financeira? O desempenho matemático é importante.

Os benchmarks de uso da ferramenta testam os recursos do MCP:

O modelo pode:

• Formatar chamadas de ferramentas corretamente?

• Escolher ferramentas apropriadas?

• Encadear várias ferramentas?

Crítico para configurações Cline usando web scraping, automação de navegador ou sistemas de memória estendida.

A limitação: os benchmarks contam apenas parte da história.

Dois modelos com pontuações semelhantes no SWE-Bench podem se destacar em coisas totalmente diferentes.

6,4K

Melhores

Classificação

Favoritos