Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

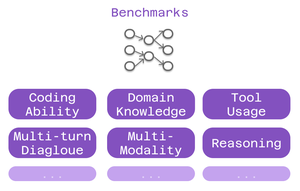

Benchmarki w świecie modeli językowych są jak testy standaryzowane w edukacji.

Wysoki wynik SAT nie gwarantuje sukcesu w każdym kierunku studiów. Podobnie, wysoki wynik benchmarku nie gwarantuje, że model będzie doskonały w każdym zadaniu.

Oto jak je mądrze interpretować. 🧵

Trzy rodzaje wskaźników są ważne dla użytkowników Cline:

> zdolność kodowania - czy potrafi rozumieć i generować kod?

> wiedza dziedzinowa - czy zna twoją dziedzinę?

> użycie narzędzi - czy potrafi pracować z integracjami MCP?

Różne wskaźniki testują różne aspekty inteligencji.

Dla programistów: SWE-Bench wyróżnia się.

Testuje modele na podstawie rzeczywistych problemów z GitHub z popularnych projektów open-source. Nie sztuczne problemy - rzeczywiste błędy i funkcje, z którymi programiści stykają się na co dzień.

Silny wynik SWE-Bench = dobry w naprawianiu błędów, wdrażaniu funkcji, refaktoryzacji rzeczywistego kodu.

Specyficzne benchmarki domenowe mają znaczenie dla wyspecjalizowanej pracy:

• MMLU - 57 przedmiotów akademickich (ochrona zdrowia, finanse, nauka)

• GPQA - Biologia, fizyka, chemia na poziomie studiów magisterskich

• AIME - Zaawansowane rozumowanie matematyczne

Budujesz aplikacje zdrowotne? Sprawdź wyniki z biologii.

Modelowanie finansowe? Wydajność matematyczna ma znaczenie.

Benchmarki użycia narzędzi testują możliwości MCP:

Czy model potrafi:

• Poprawnie formatować wywołania narzędzi?

• Wybierać odpowiednie narzędzia?

• Łączyć wiele narzędzi razem?

Krytyczne dla ustawień Cline wykorzystujących skrobanie stron internetowych, automatyzację przeglądarki lub rozszerzone systemy pamięci.

Ograniczenie: Wskaźniki wydajności mówią tylko część historii.

Dwa modele z podobnymi wynikami SWE-Bench mogą wyróżniać się w zupełnie różnych dziedzinach.

6,4K

Najlepsze

Ranking

Ulubione