Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Benchmarks i språkmodellvärlden är som standardiserade tester i utbildning.

En hög SAT-poäng garanterar inte framgång i varje högskoleämne. På samma sätt garanterar inte en hög benchmark-poäng att en modell kommer att utmärka sig vid varje uppgift.

Så här tolkar du dem klokt. 🧵

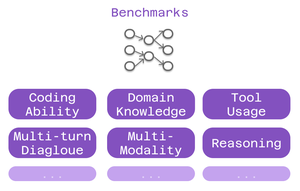

Tre typer av benchmarks är viktiga för Cline-användare:

> kodningsförmåga - kan den förstå och generera kod?

> domänkunskap - kan den ditt område?

> verktygsanvändning - kan det fungera med MCP-integrationer?

Olika riktmärken testar olika aspekter av intelligens.

För kodning: SWE-Bench sticker ut.

Den testar modeller mot verkliga GitHub-problem från populära projekt med öppen källkod. Inte artificiella problem - faktiska buggar och funktioner som utvecklare möter dagligen.

Stark SWE-Bench-poäng = bra på att fixa buggar, implementera funktioner, refaktorisera riktig kod.

Domänspecifika riktmärken är viktiga för specialiserat arbete:

• MMLU - 57 akademiska ämnen (hälso- och sjukvård, finans, naturvetenskap)

• GPQA - Biologi, fysik, kemi på avancerad nivå

• AIME - Avancerat matematiskt resonemang

Bygga appar för hälso- och sjukvård? Kontrollera biologipoängen.

Finansiell modellering? Matematiska prestationer är viktiga.

Benchmarks för verktygsanvändning testar MCP-funktioner:

Kan modellen:

• Formatera verktyget samtal korrekt?

• Välja lämpliga verktyg?

• Koppla ihop flera verktyg?

Kritiskt för Cline-installationer som använder webbskrapning, webbläsarautomatisering eller utökade minnessystem.

Begränsningen: Benchmarks berättar bara en del av historien.

Två modeller med liknande SWE-Bench-poäng kan utmärka sig på helt olika saker.

6,41K

Topp

Rankning

Favoriter