Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Reperele din lumea modelelor lingvistice sunt ca testele standardizate în educație.

Un scor SAT ridicat nu garantează succesul în fiecare specializare universitară. În mod similar, un scor de referință ridicat nu garantează că un model va excela la fiecare sarcină.

Iată cum să le interpretați cu înțelepciune. 🧵

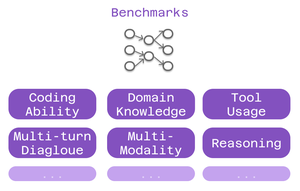

Trei tipuri de benchmark-uri contează pentru utilizatorii Cline:

> capacitate de codare - poate înțelege și genera cod?

> cunoașterea domeniului - îți cunoaște domeniul?

> utilizarea instrumentelor - poate funcționa cu integrări MCP?

Diferite repere testează diferite aspecte ale inteligenței.

Pentru codare: SWE-Bench iese în evidență.

Testează modele împotriva problemelor reale GitHub din proiecte open-source populare. Nu probleme artificiale - bug-uri și caracteristici reale cu care se confruntă zilnic dezvoltatorii.

Scor puternic SWE-Bench = bun la remedierea erorilor, implementarea caracteristicilor, refactorizarea codului real.

Reperele specifice domeniului contează pentru lucrările de specialitate:

• MMLU - 57 de discipline academice (sănătate, finanțe, știință)

• GPQA - Biologie, fizică, chimie la nivel de absolvire

• AIME - Raționament matematic avansat

Construiți aplicații de asistență medicală? Verificați scorurile de biologie.

Modelare financiară? Performanța matematică contează.

Benchmark-urile de utilizare a instrumentelor testează capacitățile MCP:

Poate modelul:

• Formatați corect apelurile instrumentelor?

• Alegeți instrumente adecvate?

• Înlănțuiți mai multe unelte împreună?

Esențial pentru configurațiile Cline care utilizează web scraping, automatizarea browserului sau sistemele de memorie extinsă.

Limitarea: Benchmark-urile spun doar o parte din poveste.

Două modele cu scoruri SWE-Bench similare ar putea excela la lucruri total diferite.

6,4K

Limită superioară

Clasament

Favorite