Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Бенчмарки в мире языковых моделей похожи на стандартизированные тесты в образовании.

Высокий балл SAT не гарантирует успеха в каждой специальности колледжа. Точно так же высокий балл бенчмарка не гарантирует, что модель будет отлично справляться с каждой задачей.

Вот как их разумно интерпретировать. 🧵

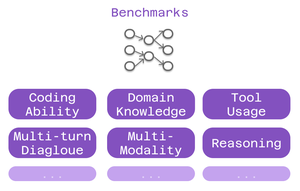

Три типа критериев важны для пользователей Cline:

> способность к кодированию - может ли он понимать и генерировать код?

> знание предметной области - знает ли он вашу сферу?

> использование инструментов - может ли он работать с интеграциями MCP?

Разные критерии тестируют разные аспекты интеллекта.

Для кодирования: SWE-Bench выделяется.

Он тестирует модели на реальных проблемах GitHub из популярных проектов с открытым исходным кодом. Не искусственные проблемы - реальные ошибки и функции, с которыми разработчики сталкиваются ежедневно.

Высокий балл SWE-Bench = хорош в исправлении ошибок, реализации функций, рефакторинге реального кода.

Специфические для домена бенчмарки важны для специализированной работы:

• MMLU - 57 академических предметов (здравоохранение, финансы, наука)

• GPQA - Биология, физика, химия на уровне аспирантуры

• AIME - Продвинутое математическое мышление

Создаете приложения для здравоохранения? Проверьте оценки по биологии.

Финансовое моделирование? Важна математическая производительность.

Эталоны использования инструментов тестируют возможности MCP:

Может ли модель:

• Правильно форматировать вызовы инструментов?

• Выбирать подходящие инструменты?

• Соединять несколько инструментов вместе?

Критически важно для настроек Cline, использующих веб-скрейпинг, автоматизацию браузера или расширенные системы памяти.

Ограничение: Бенчмарки рассказывают только часть истории.

Две модели с похожими оценками SWE-Bench могут превосходить в совершенно разных областях.

6,39K

Топ

Рейтинг

Избранное