Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Benchmarks in de wereld van taalmodellen zijn als gestandaardiseerde tests in het onderwijs.

Een hoge SAT-score garandeert geen succes in elke studierichting. Evenzo garandeert een hoge benchmarkscore niet dat een model uitblinkt in elke taak.

Hier is hoe je ze verstandig kunt interpreteren. 🧵

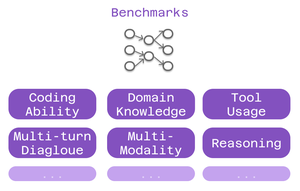

Drie soorten benchmarks zijn belangrijk voor Cline-gebruikers:

> programmeercapaciteit - kan het code begrijpen en genereren?

> domeinkennis - kent het jouw vakgebied?

> toolgebruik - kan het werken met MCP-integraties?

Verschillende benchmarks testen verschillende aspecten van intelligentie.

Voor codering: SWE-Bench springt eruit.

Het test modellen tegen echte GitHub-issues van populaire open-sourceprojecten. Geen kunstmatige problemen - daadwerkelijke bugs en functies waar ontwikkelaars dagelijks mee te maken hebben.

Sterke SWE-Bench score = goed in het oplossen van bugs, implementeren van functies, refactoren van echte code.

Domeinspecifieke benchmarks zijn belangrijk voor gespecialiseerd werk:

• MMLU - 57 academische vakken (gezondheidszorg, financiën, wetenschap)

• GPQA - Graduate-niveau biologie, natuurkunde, scheikunde

• AIME - Geavanceerd wiskundig redeneren

Bouw je gezondheidszorg-apps? Controleer de biologie-scores.

Financieel modelleren? Wiskundige prestaties zijn belangrijk.

Benchmarking van toolgebruik test de mogelijkheden van MCP:

Kan het model:

• Toolaanroepen correct formatteren?

• Geschikte tools kiezen?

• Meerdere tools aan elkaar koppelen?

Kritisch voor Cline-opstellingen die gebruikmaken van webscraping, browserautomatisering of uitgebreide geheugensystemen.

De beperking: Benchmarks vertellen slechts een deel van het verhaal.

Twee modellen met vergelijkbare SWE-Bench-scores kunnen op totaal verschillende gebieden uitblinken.

6,41K

Boven

Positie

Favorieten