Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

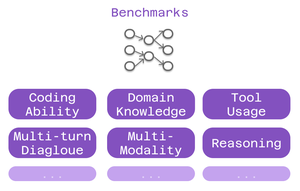

Benchmarks i språkmodellverdenen er som standardiserte tester i utdanning.

En høy SAT-poengsum garanterer ikke suksess i alle hovedfag. På samme måte garanterer ikke en høy referansepoengsum at en modell vil utmerke seg i hver oppgave.

Slik tolker du dem klokt. 🧵

Tre typer benchmarks er viktige for Cline-brukere:

> kodingsevne - kan den forstå og generere kode?

> domenekunnskap - kjenner den ditt felt?

> verktøybruk - kan det fungere med MCP-integrasjoner?

Ulike benchmarks tester ulike aspekter av intelligens.

For koding: SWE-Bench skiller seg ut.

Den tester modeller mot reelle GitHub-problemer fra populære åpen kildekode-prosjekter. Ikke kunstige problemer - faktiske feil og funksjoner utviklere møter daglig.

Sterk SWE-Bench-score = god til å fikse feil, implementere funksjoner, refaktorere ekte kode.

Domenespesifikke benchmarks er viktige for spesialisert arbeid:

• MMLU - 57 akademiske (helsevesen, finans, realfag)

• GPQA - Biologi, fysikk, kjemi på høyere nivå

• AIME - Avansert matematisk resonnement

Bygge helseapper? Sjekk biologipoeng.

Finansiell modellering? Matematiske prestasjoner er viktige.

Benchmarks for verktøybruk tester MCP-funksjoner:

Kan modellen:

• Formatere verktøyanrop riktig?

• Velge passende verktøy?

• Kjede flere verktøy sammen?

Kritisk for Cline-oppsett som bruker nettskraping, nettleserautomatisering eller utvidede minnesystemer.

Begrensningen: Benchmarks forteller bare en del av historien.

To modeller med lignende SWE-Bench-score kan utmerke seg på helt forskjellige ting.

6,39K

Topp

Rangering

Favoritter