Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

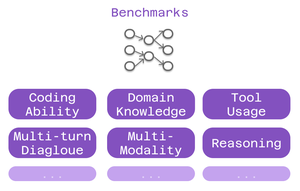

Орієнтири в світі мовних моделей схожі на стандартизовані тести в освіті.

Високий бал SAT не гарантує успіху в кожній спеціальності коледжу. Аналогічно, високий показник бенчмарку не гарантує, що модель досягне успіху в кожному завданні.

Ось як їх розумно тлумачити. 🧵

Для користувачів Cline важливі три типи контрольних показників:

> можливість кодування - чи може він розуміти і генерувати код?

> знання предметної області - чи знає вона вашу сферу?

> використання інструменту - чи може він працювати з інтеграціями MCP?

Різні бенчмарки перевіряють різні аспекти інтелекту.

Для кодування: виділяється SWE-Bench.

Він тестує моделі на реальні проблеми GitHub з популярних проектів з відкритим вихідним кодом. Не штучні проблеми - реальні баги та функції, з якими розробники стикаються щодня.

Сильний бал SWE-Bench = хороший у виправленні помилок, впровадженні функцій, рефакторингу реального коду.

Для спеціалізованої роботи мають значення орієнтири для конкретної предметної області:

• ММЛУ – 57 навчальних дисциплін (охорона здоров'я, фінанси, наука)

• GPQA - Вища освіта з біології, фізики, хімії

• AIME - Просунуті математичні міркування

Створюєте додатки для охорони здоров'я? Перевірте результати з біології.

Фінансове моделювання? Успішність з математики має значення.

Тестові можливості тесту MCP бенчмарків використання інструменту:

Чи може модель:

• Правильно форматувати виклики інструментів?

• Вибрати відповідні інструменти?

• З'єднати кілька інструментів разом?

Критично важливо для налаштувань Cline з використанням веб-скрейпінгу, автоматизації браузера або систем розширеної пам'яті.

Обмеження: Бенчмарки розповідають лише частину історії.

Дві моделі з однаковими показниками SWE-Bench можуть досягти успіху в абсолютно різних речах.

6,39K

Найкращі

Рейтинг

Вибране